05 Nov ¿La IA juega a favor o en contra de las personas?

El tema no se ha dejado de discutir en los últimos años dentro de círculos especializados pero, actualmente, se ha convertido en tendencia: el uso que se le da a los datos que entregamos cuando estamos en las redes sociales.

El documental The Social Dilemma (2020) de Jeff Orlowski ha puesto el tema nuevamente en el panorama. Según Forbes, este film fue el más visto en Netflix en septiembre.

Las discusiones posteriores al lanzamiento del documental no han parado: foros en Reddit, publicaciones y comentarios en Linkedin, webinars y podcasts dedicados al tema y mucho más.

Que se hable del tema es un fenómeno positivo. Por tal razón, nos queremos sumar a la conversación con una serie de puntos que deberían ser tomados en cuenta:

Desde 2012 se nos ha advertido de “la huella digital”

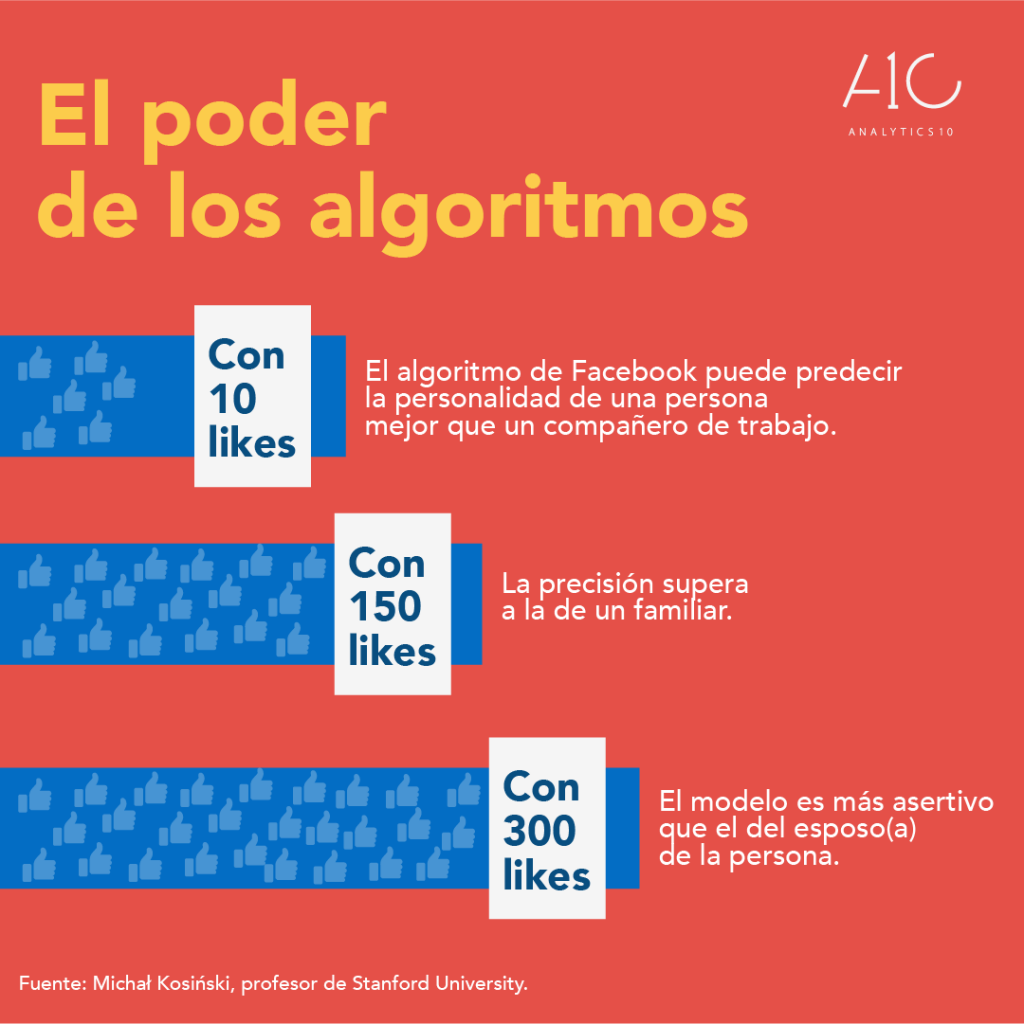

El profesor de comportamiento organizacional en la Universidad de Stanford, Michał Kosiński, demostró en 2012 que con 68 likes de Facebook, se podía predecir el color de una persona con una precisión de 95%; su orientación sexual en 88% y su orientación política en 85%. Además, se podía deducir su nivel inteligencia, si consumía drogas y alcohol, su creencia religiosa e, incluso, si sus padres estaban separados.

Kosiński, resume su especialidad de esta manera: “estudio a humanos en un entorno digital utilizando métodos computacionales de vanguardia, IA y Big Data”. Kosiński es Dr. en Psicología por la Universidad de Cambridge y ha publicado decenas de artículos científicos. Se le conoce por ser de los primeros en hablar sobre “la huella digital” que dejan las personas cuando usan las redes sociales.

“Los detalles de nuestra vida privada están a un clic de gobiernos, organizaciones y empresas”, explica. Esta realidad no es un gran secreto. El problema está en cómo esa información puede ser utilizada. De allí las advertencias de Kosiński acerca del uso de las redes sociales.

La huella digital que las personas dejan en internet comprende información como sexo, edad, orientación sexual, gustos musicales y políticos, en qué tiendas compran, de quiénes son amigos, qué profesión ejercen, restaurantes favoritos, últimos viajes realizados y un sinfín de cosas más, según el profesor.

En una entrevista con Revista Capital, Kosinski aclara que no basta estar online para dejar huella. Todo lo que hacemos, también offline, deja rastros digitales: las compras con tarjeta, los movimientos mientras estamos con el teléfono en el bolsillo, etc. Según el Dr. en psicología, nuestros celulares son un vasto cuestionario que está siendo rellenado constantemente, tanto de manera consciente como inconsciente.

El incómodo problema de la privacidad

Cuatro años después, el tema volvió a ser tendencia mundial. Se descubrió que Cambridge Analytica, una empresa de análisis de datos y comunicación estratégica, había utilizado Facebook como herramienta para manipular a votantes estadounidenses.

En 2016, la campaña de Trump se apoyó en esta empresa para crear y registrar perfiles psicodemográficos que les permitieran sugestionar a millones de usuarios de Facebook.

Meses antes de conocerse el escándalo, el profesor Kosinski ayudó a escribir un artículo en The Guardian que advertía lo que el partido republicano y Cambridge Analytica estaban haciendo. Ted Cruz using firm that harvested data on millions of unwitting Facebook users fue el titular de aquella nota.

No todo quedó en la anécdota.

En julio de 2017, a menos de 1 año del triunfo electoral de Donald Trump en Estados Unidos, Michał Kosiński vino a Chile a dictar la conferencia “Inteligencia Artificial y el fin de la privacidad y sus efectos en negocios, gobiernos y personas”. Este evento se realizó gracias a las gestiones de Analytics10 y el Diario Financiero.

La conferencia del profesor de Stanford se centró en cómo la campaña Trump utilizó perfiles psicodemográficos similares a los que él había usado en 2012 para su investigación. En resumen, la información estaba disponible y el peligro es que podía ser usada para propósitos de cualquier tipo de naturaleza.

A partir de esta premisa, Kosiński disertó sobre cómo empresas, gobiernos y ciudadanos deben prepararse ante este escenario. Los números son claros:

En una entrevista con Diario Financiero, Kosinski habla sobre la diatriba en la que se encuentra la sociedad actualmente:

“El uso de psicología en campañas políticas puede ser bueno en el sentido de que el mensaje se adapta al ciudadano que va a votar. Un programa político normalmente es muy extenso para poder ser digerido por los votantes. Por lo tanto, el poder adaptar el mensaje a lo que es importante para cada uno es óptimo, y lleva a que los electores estén mejor informados al momento de votar”.

Sin embargo, esta realidad también tiene su contraste, como lo describe el profesor: “para las campañas del Brexit y Donald Trump se habrían usado tecnologías para manipular a los electores. Obviamente no son las analíticas de big data las que ganan las elecciones. Son los candidatos. Pero no sabemos cuánto fueron ayudados por estos análisis”.

Los beneficios de la IA están a la vista

“El mayor beneficiario de la inteligencia artificial es el ciudadano”, asegura Kosinski. A pesar de las inquietudes, el profesor considera que la IA ha generado enormes avances para las personas.

En una entrevista para el podcast Inequalities de Alice Krozer, el profesor de Stanford expuso su visión acerca del futuro de las tecnologías. Para Kosinski, la inteligencia artificial ha masificado los beneficios y las posibilidades para las personas y, por tal razón, se nuestra positivo al respecto.

“El mismo algoritmo que se usa para que una persona consuma alcohol, cigarrillos o vote por un político, puede ser empleado para estimular/ayudarle a estudiar más, tener una dieta saludable, mantener contacto con familiares y seres queridos, ser más felices”, explica el profesor.

Acceso a la educación

“La manipulación de un algoritmo puede representar la educación de una persona. El problema es cuando esas técnicas son usadas en nuestra contra”, explica.

Kosinski hace especial énfasis en el acceso a la educación que proveen los algoritmos, la tecnología y la inteligencia artificial. “De repente, casi todas las personas a lo largo del planeta que tengan un teléfono inteligente pueden tener acceso a canales de educación, información y comunicación que en el pasado estaban reservados para los millonarios”.

El profesor de Stanford destaca casos como el de Khan Academy, Udacity y muchas otras plataformas de educación online que entregan programas de formación de calidad y que son consumidos ya no solo por estudiantes de Estados Unidos y Europa, sino por jóvenes de otros países con realidades más complicadas.

El acceso al trabajo

“En el pasado, si querías trabajar en una gran compañía de tu industria, necesitabas vivir cerca de dicha empresa. Tenías que moverte, así no lo quisieras”, explica Kosinski.

Actualmente, una persona que viva en una pequeña villa de la India puede competir y aplicar a la misma vacante que un profesional que viva en San Francisco.

Para Kosinski, esta nueva realidad está trayendo fenómenos interesantísimos. “De alguna manera, las personas que viven en lugares menos privilegiados están obteniendo mayores beneficios en el mercado laboral. Al aplicar a los mismos trabajos que las personas que viven en las grandes ciudades, están accediendo a los mismos sueldos pero se ahorran los altos costos de la vida (arriendo, comida, transporte, etc.)”, detalla.

Acceso a vivienda y cambios en el mercado inmobiliario

La transición al teletrabajo está generando cambios importantes en la movilidad de las personas. Una investigación reciente de The Wall Street Journal ha detectado que la demanda de arriendos de departamentos en los suburbios de Estados Unidos ha estado aumentando en los últimos meses.

Todo apunta a que el trabajo remoto no dejará de crecer, incluso en un escenario post pandemia. En Estados Unidos, los profesionales han comenzado a mudarse de las grandes ciudades. Están optando por lugares más abiertos y tranquilos, puesto que en definitiva ya no necesitan vivir cerca de la oficina.

The corporate obsession with the glamour and imagined creativity of the office has forced so many people to live in a place they would rather have not for far too long. This tragic attack on the well-being of millions is finally unwinding. Way over due. https://t.co/LSTxRFDbXE

— DHH (@dhh) October 14, 2020

Este cambio de paradigma refuerza la libertad de los trabajadores de vivir donde deseen y no condicionar su decisión a la variable trabajo.

Kosinski explica que el factor vivienda y ubicación representa un cambio radical. En su criterio, las personas que viven en pueblos pequeños y desfavorecidos tendrán la oportunidad de acceder a mejores ofertas de trabajo. No se tienen que condicionar a las posibilidades del lugar donde se encuentran.

“Un mexicano que vive en un pequeño pueblo puede aplicar a un trabajo en la CDMX, sin necesidad de mudarse… y más: si ya ha logrado conseguir un trabajo en la capital del país, ¿por qué no aplicar a un trabajo en Estados Unidos o Europa?”, se cuestiona el profesor.

Nuevos mercados y transformación

Según el Banco Mundial, América Latina es la región más afectada por el Covid-19. Hasta el momento, se han perdido más de 149 millones de empleos. La entidad explica que Latinoamérica no vivía un escenario tan complejo desde 2005.

Sin embargo, hoy en día, las condiciones son distintas.

El sector servicios es el más relevante en países como México y Brasil, una realidad similar al resto de la región. Es una ventaja interesante ya que la tecnología y la inteligencia artificial pueden ser herramientas de enorme ayuda para mejorar la productividad y rentabilidad del sector.

Ya en 2017 Kosinski explicaba este escenario en una entrevista: “las empresas pueden ajustar mejor sus productos a la demanda real que existe. Ya no necesitan pasar por una serie de filtros, como agencias de publicidad que interpretan estudios difusos. Hoy, las campañas de marketing pueden llegar a ser inmediatas, reaccionando en tiempo casi real a lo que está ocurriendo alrededor. Las empresas ágiles que adopten una nueva forma de operar llevarán una clara ventaja”.

Creación de soluciones eficientes

Las entidades públicas y gobiernos cuentan con las herramientas tecnológicas necesarias para conectar con los ciudadanos, entender sus necesidades, detectar y prevenir problemas o catástrofes.

Actualmente, existen soluciones de inteligencia artificial con foco social capaces de detectar las problemáticas que más preocupan a un grupo determinado de personas, miembros de una comunidad, región, ciudad o país.

Soluciones de IA como Citibeats ha ayudado a decenas de organizaciones públicas y privadas a desarrollar proyectos de análisis y predicción de problemáticas sociales; los resultados han sido muy positivos.

La tarea pendiente: impulsar una ética de la inteligencia artificial y la robótica

A pesar de este escenario positivo, el debate sobre el uso indiscriminado de los datos de las personas sigue muy activo y continúa generando dificultades.

En su artículo Ethics of Artificial Intelligence and Robotics, Vincent Müller, profesor de filosofía de la Universidad Tecnológica de Eindhoven explica que la inteligencia artificial y la robótica son tecnologías digitales que tendrán un impacto significativo en el desarrollo de la humanidad en un futuro próximo.

Sin embargo, dado el actual panorama, las sociedades están obligadas a responder preguntas fundamentales sobre qué se debería hacer con estos sistemas, qué deberían hacer los propios sistemas, qué riesgos implican y cómo pueden ser controlados.

Al respecto, Müller profundiza en dos debates en los que empresas, gobiernos y sociedades deben entrar para tratar de conseguir soluciones y propuestas efectivas:

1. Privacidad y vigilancia

Según el profesor de filosofía, los estudios de privacidad se han centrado históricamente en la vigilancia estatal por parte de los servicios secretos, pero actualmente están incluyendo la vigilancia de otros agentes estatales, empresas e incluso personas.

“La tecnología ha cambiado significativamente en las últimas décadas, mientras que la regulación ha tardado en responder; el resultado es una cierta anarquía que es explotada por los jugadores más poderosos, a veces a simple vista, a veces a escondidas”, explica Müller.

No es un secreto que el mundo genera millones de datos diarios; también es conocido que esta tendencia no hará más que crecer exponencialmente. La IA aumenta tanto las posibilidades de recopilación de datos inteligente como las posibilidades de análisis de datos. Esto se aplica a la vigilancia general de poblaciones enteras, así como a la vigilancia dirigida clásica.

“Además, muchos de los datos se intercambian entre agentes, generalmente por una tarifa”, detalla el profesor. Este es uno de los puntos más importantes y críticos de la discusión.

En su libro Secrets and Lies: Digital Security in a Networked World, Bruce Schneier tiene una opinión crítica al respecto: “el enfoque principal de las redes sociales, los juegos y la mayor parte de internet en esta “economía de la vigilancia” es ganar, mantener y dirigir la atención y, por lo tanto, el suministro de datos. La vigilancia es el modelo de negocio de internet”.

Sin embargo, autores como Müller reconocen que las técnicas de preservación de la privacidad que pueden ocultar en gran medida la identidad de personas o grupos son ahora un elemento básico estándar en la ciencia de datos; incluyen anonimización (relativa), control de acceso (más cifrado) y otros modelos en los que el cálculo se realiza con datos de entrada total o parcialmente cifrados.

Si bien requieren más esfuerzo y costos, estas técnicas pueden evitar muchos problemas de privacidad. No en vano, cientos de empresas han encontrado en la privacidad una ventaja competitiva que se puede aprovechar y vender a buen precio.

No obstante, un factor en el que se sigue fallando yace en la regulación. Para Müller, la seguridad legal para los derechos del consumidor, la responsabilidad del producto y la protección de derechos de propiedad intelectual suele fallar cuando se trata de productos digitales o, en su defecto, se hace muy difícil de hacer cumplir.

2. Manipulación del comportamiento

Para el profesor de psicología, los esfuerzos para manipular el comportamiento de las personas son antiguos, pero han adquirido una nueva cualidad con el uso de sistemas de IA.

“Dada la intensa interacción de los usuarios con los sistemas de datos y el profundo conocimiento que se genera de dicha actividad, las personas son vulnerables a los ‘impulsos/estímulos’ de manipulación y engaño”, señala Müller.

Según el filósofo, con base en cierta cantidad de datos, los algoritmos pueden ser utilizados para apuntar mensajes, ideas o estímulos a distintos grupos de personas y persuadirlos a realizar alguna acción.

El problema crece cuando se asume que las soluciones de inteligencia artificial y machine learning deben entrenarse con grandes cantidades de datos. Para Müller, esta realidad genera una tensión muy fuerte en el equilibrio entre la privacidad y los derechos a los datos frente a la calidad técnica de un producto o servicio.

Dado el escenario, Müller invita a pensar en soluciones transversales. El filósofo destaca los esfuerzos que ha realizado la Unión Europea con su Reglamento General de Protección de Datos. Sin embargo, muchos más agentes públicos y privados deben sumarse a estos esfuerzos que se centran en los intereses de la sociedad en general.

8 etapas para una Inteligencia Artificial ética (Framework)

El departamento de Industria, Ciencia, Energía y Recursos de Australia es una de las entidades públicas que mayores avances ha dado en el desarrollo de capacidades de inteligencia artificial enfocadas en el bienestar de la sociedad.

Como parte de sus esfuerzos, han desarrollado un marco ético de Inteligencia Artificial para instituciones públicas y privadas que deseen desarrollar soluciones de IA y ML.

#1 Bienestar humano, social y medioambiental

A lo largo de su ciclo de vida, los sistemas de IA deben beneficiar a las personas, la sociedad y el medio ambiente.

#2 Valores centrados en el ser humano

A lo largo de su ciclo de vida, los sistemas de IA deben respetar los derechos humanos, la diversidad y la autonomía de las personas.

#3 Equidad:

A lo largo de su ciclo de vida, los sistemas de IA deben ser inclusivos, accesibles, y no deben involucrar ni dar lugar a discriminaciones contra personas, comunidades o grupos.

#4 Protección y seguridad de la privacidad

A lo largo de su ciclo de vida, los sistemas de inteligencia artificial deben respetar y defender los derechos de privacidad y garantizar la seguridad de los datos.

#5 Fiabilidad y seguridad

A lo largo de su ciclo de vida, los sistemas de inteligencia artificial deben funcionar de manera confiable de acuerdo con su propósito previsto.

#6 Transparencia y sencillez

Debe existir transparencia y divulgación responsable para garantizar que las personas sepan cuándo están siendo afectadas significativamente por un sistema de IA y que puedan averiguar cuándo un sistema de IA está interactuando con ellos.

#7 Cuestionabilidad

Cuando un sistema de IA impacta significativamente a una persona, comunidad, grupo o entorno, debe existir un proceso oportuno para que las personas cuestionen el uso o la salida de dicho sistema.

#8 Responsabilidad

Los desarrolladores y gestores de las diferentes fases del ciclo de vida del sistema de inteligencia artificial deben ser identificables y responsables de los resultados. Asimismo, se debe habilitar la supervisión humana a los sistemas de inteligencia artificial.

Conclusión

La conversación que hoy en día se está dando en foros y seminarios acerca del documental de Jeff Orlowski es más que positiva. Asimismo, se puede evidenciar que las ideas e investigaciones del profesor Michał Kosiński siguen muy vigentes.

Visualizar la incidencia de inteligencia artificial en la vida cotidiana de las personas y tomar decisiones relevantes al respecto es una tarea pendiente para gobiernos y empresas. Es crítico levantar acuerdos comunes que se centren en el bienestar de la sociedad general.